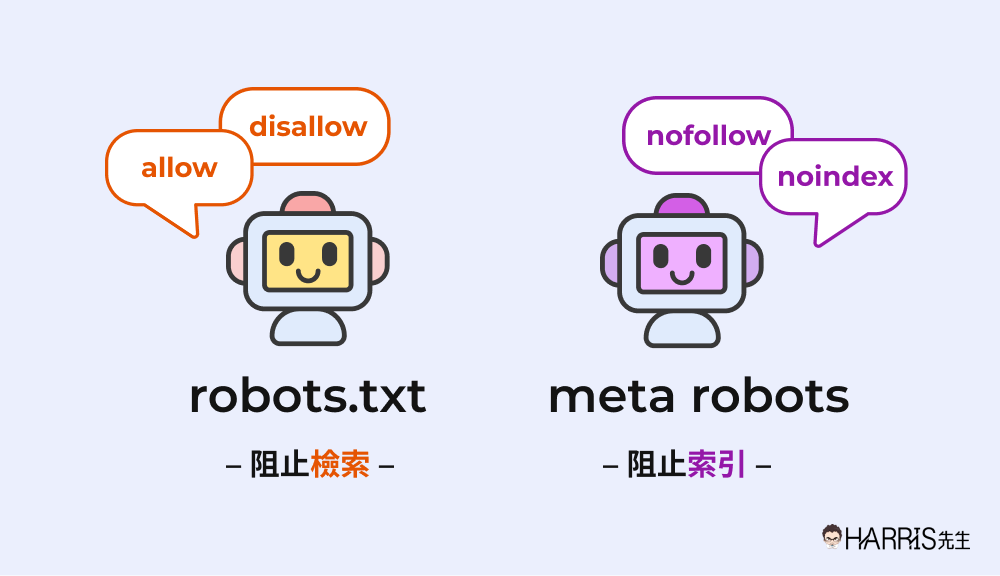

合理使用 robots.txt 與 noindex 指令來管理爬蟲預算,關鍵在於兩者的功能與限制要分清楚,並避免同時錯誤使用。

-

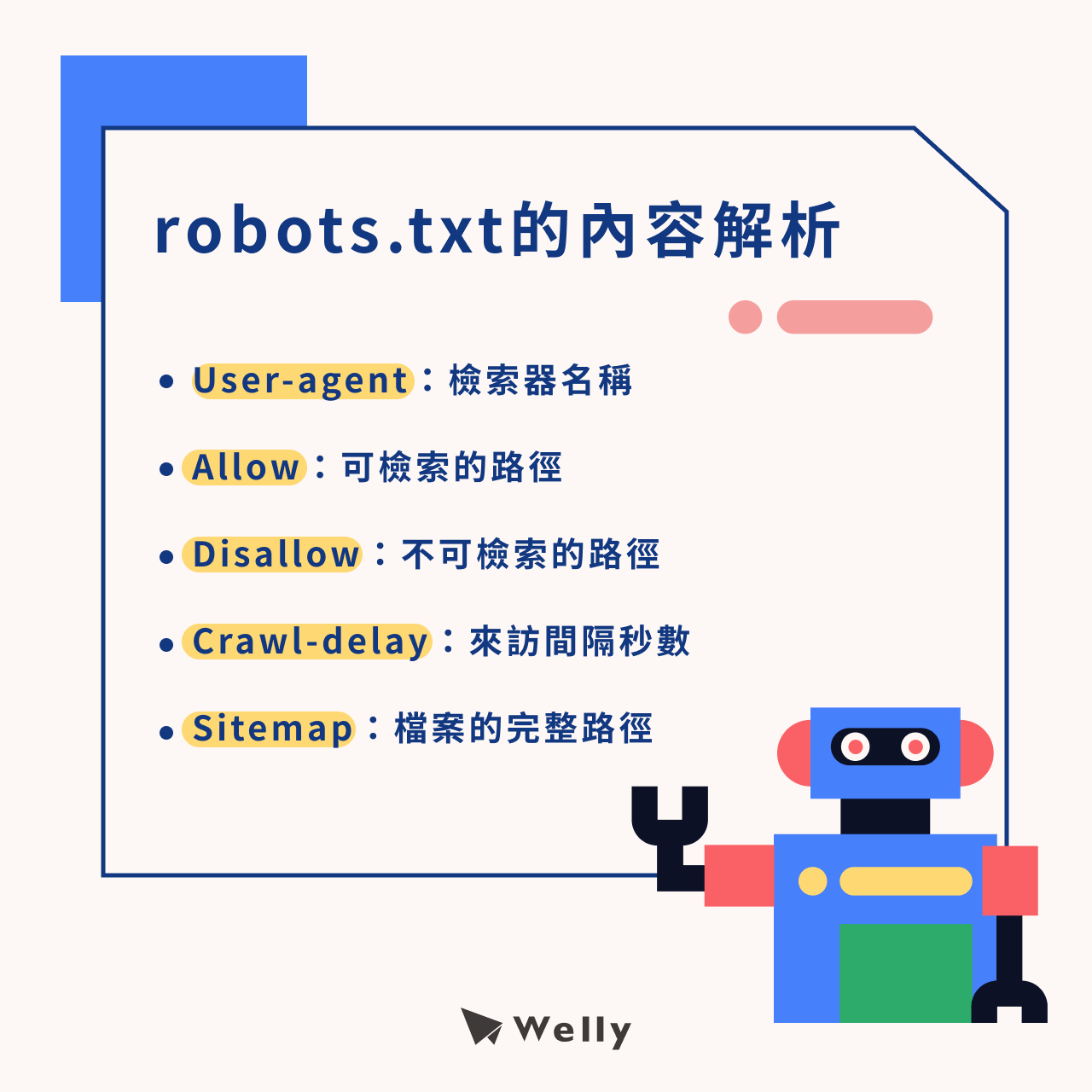

robots.txt 用於控制爬蟲「爬行(Crawling)」網站的權限,透過

Disallow指令阻止爬蟲訪問特定頁面或資料夾,從而節省爬蟲資源(爬蟲預算)。但被阻止爬行的頁面,爬蟲無法讀取頁面內容與 meta 標籤,因此無法識別noindex指令。 -

noindex 指令則用於控制「索引(Indexing)」,告訴搜尋引擎不要將該頁面納入搜尋結果。它通常以

<meta name="robots" content="noindex">標籤或 HTTP 回應標頭的形式實現。重要的是,該頁面必須對爬蟲可見(即未被 robots.txt 阻擋),爬蟲才能讀取並執行noindex指令。

因此,最佳做法是:

-

若希望節省爬蟲預算,避免爬行不重要或重複內容,使用 robots.txt 的

Disallow阻擋爬行。 -

若希望頁面被爬行但不被索引(例如感謝頁、內部搜尋結果頁),使用

noindex指令,且不要在 robots.txt 阻擋該頁面,確保爬蟲能讀取noindex。 -

不建議在 robots.txt 使用

noindex,因為 Google 不支持此用法,且可能導致指令無效。 -

避免同時對同一頁面使用

Disallow和noindex,以免爬蟲無法讀取noindex,導致頁面仍被索引。 -

使用 Google Search Console 的 robots.txt 測試工具和 URL 檢查工具,確認設定是否生效,避免誤封重要頁面或洩露敏感資訊。

所以,合理管理爬蟲預算的策略是:用 robots.txt 控制爬行範圍,用 noindex 控制索引狀態,兩者分工明確且互不干擾,才能達到最佳效果。

WebSeoHK 為香港、澳門和內地提供業界最優質的網站流量服務。我們為客戶提供多種流量服務,包括網站流量、桌面流量、行動流量、Google流量、搜索流量,電商流量、YouTube流量、TikTok流量。我們的網站擁有 100% 的客戶滿意度,因此您可以放心地在線購買大量 SEO 流量。每月僅需 90 港幣即可立即增加網站流量、提高 SEO 效能並增加銷售額!

您在選擇流量套餐時遇到困難嗎?聯繫我們,我們的工作人員將協助您。

免費諮詢