Disallow 與 Allow 指令在 robots.txt 中用於精細控制搜尋引擎爬蟲對網站內容的訪問權限。Disallow 指令用來明確禁止爬蟲抓取特定目錄或頁面,而 Allow 指令則用於例外允許某些被 Disallow 阻擋範圍內的特定路徑或檔案被爬取。

精細運用技巧包括:

-

結合使用 Disallow 與 Allow 以達到例外控制

例如,禁止整個目錄,但允許該目錄下的某些檔案或子目錄被抓取:Disallow: /private/ Allow: /private/public-info.html這樣可以阻止爬蟲抓取 /private/ 目錄下大部分內容,但允許抓取 public-info.html。

-

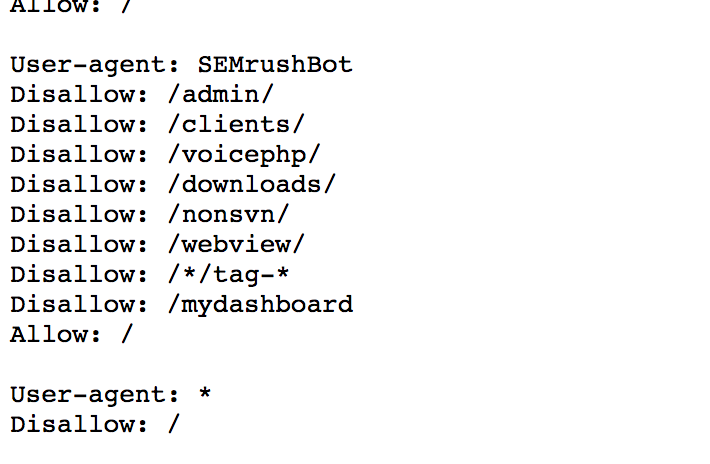

針對不同爬蟲設定不同規則

透過多個 User-agent 區塊,分別為特定爬蟲設置不同的 Disallow 和 Allow,實現更精細的控制:User-agent: Googlebot Disallow: /no-google/ User-agent: * Disallow: /private/ Allow: /private/allowed.html這樣可針對 Googlebot 與其他爬蟲分別限制訪問範圍。

-

使用通配符與特殊符號

*表示任意字元,$表示結尾,能精確匹配 URL 模式。- 例如,阻擋所有帶有參數的網址(含

?):Disallow: /*? - 但允許以

?結尾的網址:Allow: /*?$

這種用法可避免重複內容被抓取,提升 SEO 效果。

-

允許特定功能性檔案訪問

例如 WordPress 中常見的 ajax 請求檔案,雖然整個管理目錄被禁止,但允許 admin-ajax.php 被抓取:Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php這樣確保網站功能正常同時限制爬蟲訪問敏感區域。

-

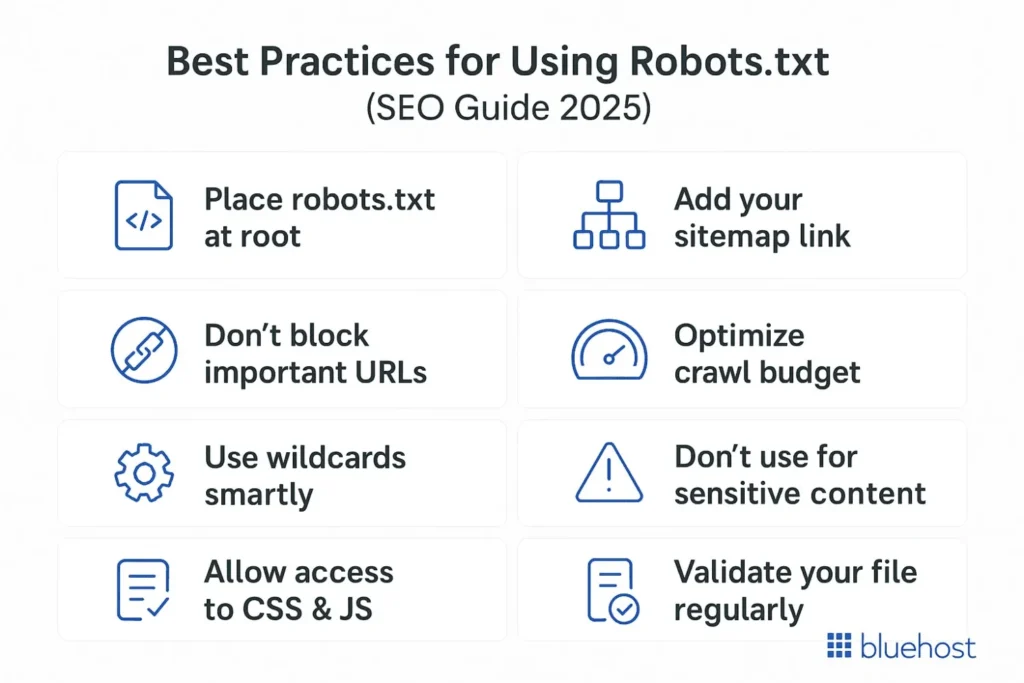

結合 Sitemap 指令提升爬取效率

在 robots.txt 中加入 Sitemap 路徑,幫助爬蟲更有效率地發現網站頁面,配合 Disallow/Allow 指令達到最佳 SEO 效果。

所以,Disallow 與 Allow 指令的精細運用關鍵在於結合多條規則、針對不同爬蟲分別設置、利用通配符精確匹配 URL 模式,以及例外允許特定重要資源訪問,從而達到最佳的爬取控制與網站優化效果。

WebSeoHK 為香港、澳門和內地提供業界最優質的網站流量服務。我們為客戶提供多種流量服務,包括網站流量、桌面流量、行動流量、Google流量、搜索流量,電商流量、YouTube流量、TikTok流量。我們的網站擁有 100% 的客戶滿意度,因此您可以放心地在線購買大量 SEO 流量。每月僅需 90 港幣即可立即增加網站流量、提高 SEO 效能並增加銷售額!

您在選擇流量套餐時遇到困難嗎?聯繫我們,我們的工作人員將協助您。

免費諮詢