針對多語言網站的 robots.txt 設計策略與實務建議,主要目標是確保搜索引擎能正確且有效地爬取並索引各語言版本的內容,同時避免重複內容和資源浪費。

以下是具體策略與實務建議:

-

明確允許各語言版本的頁面被爬取

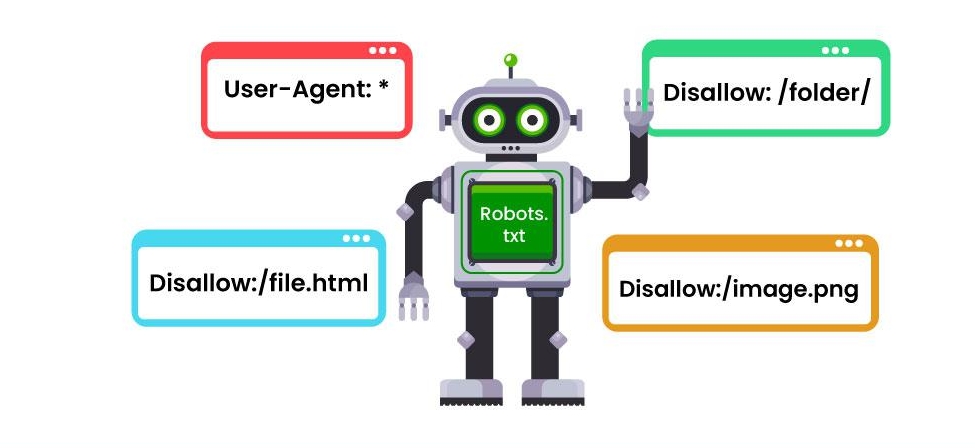

在 robots.txt 中應確保沒有阻擋各語言版本的主要網頁路徑,讓搜索引擎能訪問並索引所有語言版本。例如,若網站有 /en/、/zh/ 等語言子目錄,robots.txt 不應禁止這些路徑。 -

避免阻擋重要資源與語言切換功能

多語言網站常用 JavaScript、CSS、圖片等資源來實現語言切換與頁面呈現,robots.txt 不應阻擋這些資源,否則可能影響搜索引擎對頁面內容的理解和索引。 -

利用 Sitemap 指令指向多語言站點地圖

在 robots.txt 中加入 Sitemap 指令,指向包含所有語言版本頁面的 XML Sitemap,有助搜索引擎更快發現並索引多語言內容。 -

避免重複內容的爬取

若多語言網站存在重複內容(如不同語言版本結構相似),可透過 robots.txt 阻擋不必要的重複頁面或次要內容,節省爬蟲資源,但不應阻擋所有重複頁面,因為這些頁面仍需被索引。 -

配合 hreflang 標籤使用

雖然 robots.txt 不直接設定 hreflang,但多語言網站應在頁面中正確使用 hreflang 標籤,告訴搜索引擎不同語言版本的對應關係,robots.txt 設計則需配合確保這些頁面可被爬取。 -

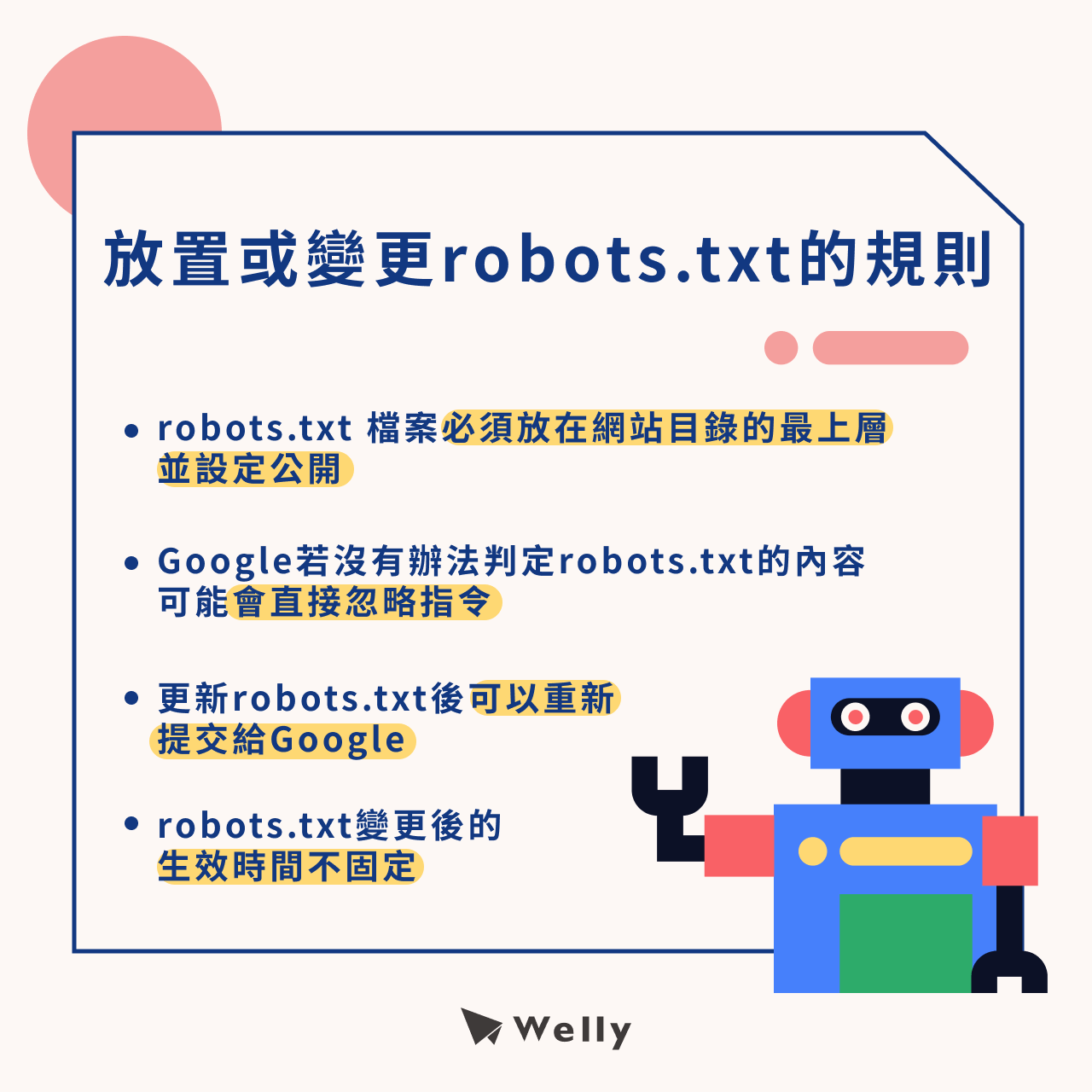

定期檢查與更新 robots.txt

隨著網站結構和語言版本的變動,應定期檢查 robots.txt 規則,確保不會誤阻重要頁面或資源,並利用 robots.txt 測試工具驗證設定正確。 -

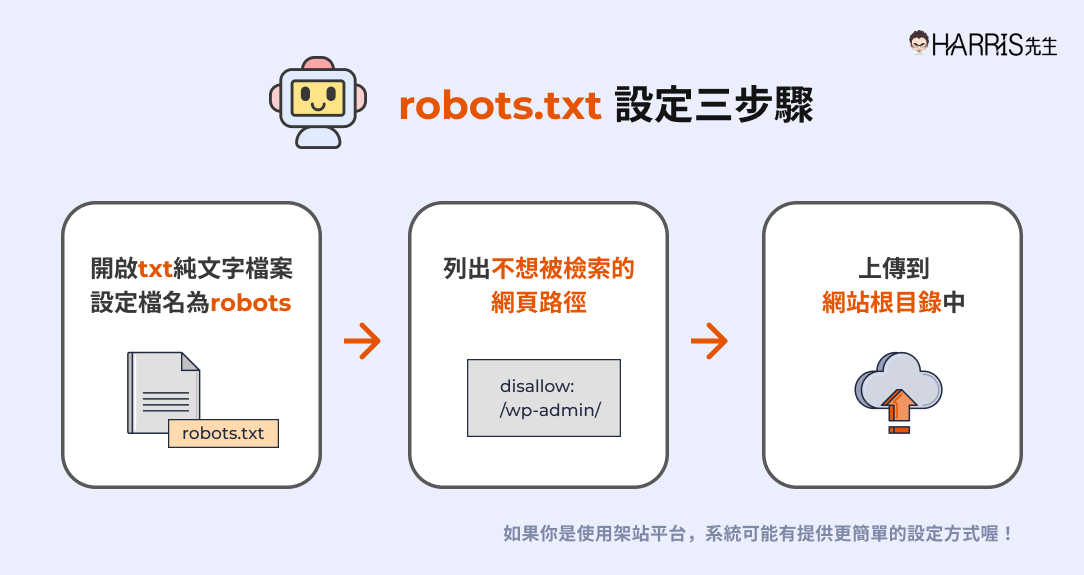

robots.txt 範例簡述

User-agent: * Allow: /en/ Allow: /zh/ Disallow: /admin/ Sitemap: https://www.example.com/sitemap.xml此範例允許所有爬蟲訪問英文與中文目錄,阻擋後台管理頁面,並指向站點地圖。

所以,多語言網站的 robots.txt 設計應以允許所有語言版本的主要頁面被爬取、避免阻擋重要資源、配合 sitemap 和 hreflang 使用為核心,並定期檢查更新,確保搜索引擎能有效索引多語言內容,提升 SEO 效果。

WebSeoHK 為香港、澳門和內地提供業界最優質的網站流量服務。我們為客戶提供多種流量服務,包括網站流量、桌面流量、行動流量、Google流量、搜索流量,電商流量、YouTube流量、TikTok流量。我們的網站擁有 100% 的客戶滿意度,因此您可以放心地在線購買大量 SEO 流量。每月僅需 90 港幣即可立即增加網站流量、提高 SEO 效能並增加銷售額!

您在選擇流量套餐時遇到困難嗎?聯繫我們,我們的工作人員將協助您。

免費諮詢